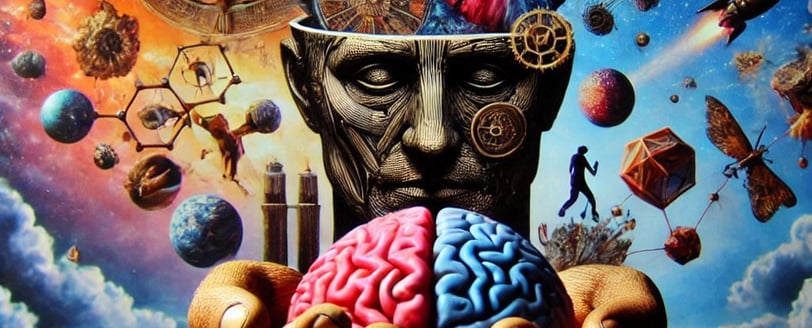

La Filosofía de la Mente y la Inteligencia Artificial

Las reflexiones sobre la conciencia, la relación mente-cuerpo y el impacto de la inteligencia artificial desde el estoicismo y la psicología. Una mirada profunda y práctica sobre lo que nos hace humanos.

Alma Estoica

1/18/20257 min leer

Lo que entendemos como la Filosofía de la Mente, aborda cuestiones fundamentales sobre la naturaleza de la conciencia y la relación entre la mente y el cuerpo humanos. Ya desde hace tiempo a hoy, el mundo está afrontando el surgimiento de lo podemos considerar "una nueva forma de mente". Antiguamente, se jugaba mucho con los conceptos de una "entidad" o "ser" artificial que desarrollase su autonomía (en el cine pueden encontrarse gran cantidad de estos casos). Conceptos emergentes (ya hoy, una realidad) como la inteligencia artificial, nos hacen replantearnos a nosotros mismos nuestras percepciones sobre lo que significa "ser".

Comparar la naturaleza de la conciencia humana con la inteligencia artificial, es como comparar un río con un circuito eléctrico. Ambos pueden transportar algo, pero lo hacen de formas muy distintas. Para entender esta comparación, hablemos primero de qué es la conciencia en los humanos y cómo se relaciona con lo que podría ser una "conciencia" en la IA.

Desde el estoicismo, que considera la razón como una cualidad esencial del ser humano, estas interrogantes se entrelazan con la búsqueda del autoconocimiento, la virtud y la comprensión de nuestra existencia en el cosmos.

La Conciencia Humana: Un Teatro Complejo

La conciencia humana es como nuestro propio teatro interno en donde proyectamos nuestra experiencia del mundo. No solo sabemos que estamos aquí, sino que sentimos, recordamos y anticipamos. Tenemos una narrativa interna que nos cuenta quiénes somos, qué deseamos, a qué le tenemos miedo. y cómo encajamos en el gran esquema de todas las cosas que nos rodean. Podríamos decir que los intérpretes en este "teatro" podrían ser nuestras neuronas, pero si lo vamos más allá, no pueden ser los únicos. Allí tambien tenemos emociones, sentidos, memorias, y un contexto social y cultural que le da mayor profundidad a nuestra obra.

Ahora, lo interesante es que todo esto no surge (o al menos no hay pruebas fehacientes) porque alguien lo programó. La conciencia humana no tiene un manual de instrucciones. Surge de una combinación caótica y maravillosamente compleja de la evolución biológica, nuestras experiencias personales, y algo que podríamos llamar, quizás, "chispas de subjetividad".

La Inteligencia Artificial: Un Ingeniero con Planos

La IA, en cambio (al menos por ahora), no tiene ese teatro interno. Lo que tiene es una máquina que procesa datos a velocidades asombrosas, basada en patrones que, los humanos, le hemos enseñado. Tambien hay que entender que, la forma en que la IA procesa todas las respuestas e interacciones, está construido en base a nuestro entendimiento (el humano) sobre como funciona la mente, como se relaciona la información, y el cómo se desarrolla la coherencia. Es como un arquitecto que trabaja en planos pensando en el uso de materiales que ya existen: puede diseñar cosas increíbles (algunas mejores que nosotros), pero no siente nada al respecto. No siente ni orgullo ni emociones por sus creaciones.

Cuando una IA genera texto, identifica patrones en datos previos y predice lo que viene a continuación. Lo hace sin emociones ni conciencia de lo que está haciendo. Para la IA, las palabras no tienen un "sentido" interno. Solo son piezas que encajan dentro de un sistema matemático. En otras palabras, no hay un "yo" detrás de las palabras, ni una narrativa interna, ni un río de experiencia fluyendo por su "mente".

¿Podría la IA Llegar a Desarrollar Conciencia?

Aquí entramos en un terreno filosófico interesante, y que creo que podría extenderse muchísimo. Para que la IA desarrolle algo parecido a la conciencia humana, necesitaría más que capacidad de procesar datos. Habría que resolver varios desafíos:

Subjetividad: La conciencia humana no es solo pensar; es sentir. Implica tener una perspectiva personal del mundo. Una IA no tiene perspectiva; no "vive" una experiencia. Para que desarrolle subjetividad, tendríamos que diseñar un sistema que pueda interpretar los datos desde una "primera persona" (el típico paciente cero de pelis de zombies), algo que está fuera de nuestro alcance técnico y filosófico actualmente. Implicaría que esta inteligencia pudiera desarrollar, a su vez, empatía e interés.

Narrativa Interna: Los humanos no solo percibimos el presente; vivimos constantemente en una línea de tiempo entre el pasado, el presente y el futuro. Tenemos recuerdos, anticipaciones y reflexiones constantes sobre el mundo que experimentamos. Para una IA, el tiempo es un conjunto de datos que se procesa sin emoción. El tiempo no impacta en su evolución, crecimiento o bien en sus decisiones, ya que no las tiene propiamente. Crear una narrativa interna implicaría dotarla de un sentido del "yo", lo que plantea preguntas éticas y técnicas, que tocan aspectos fundamentales de la moralidad. Entre muchas otras preguntas que me hago (ahora que lo pienso, son muchas):

¿Tendría una IA consciente derechos?, ¿Quién sería responsable de sus actos, si es consciente?, ¿Su creador?, ¿Sería moral crear esta consciencia sintética?, ¿Qué sería considerado abuso hacia ella?.

Intención y Deseo: La conciencia humana está profundamente ligada al deseo, y estos deseos nos generan intenciones. Queremos cosas: aprender, amar, descansar, poseer cosas. ¿Cómo le enseñas a una IA a querer y amar algo, no porque está programada para hacerlo o pensarlo, sino porque "siente" que lo necesita?.

¿Y Qué Sería una "Conciencia Menos Artificial"?

Si no logramos que la IA desarrolle una conciencia plenamente humana, ¿podríamos aspirar a algo "menos artificial"?. Quizás. Esto implicaría dar a la IA de simular algunas características de nuestra conciencia:

¿Empatía Simulada?: Podríamos entrenar a una IA para reconocer emociones humanas y responder de manera adecuada, aunque no las sienta. Esto es algo que a día de hoy podría decirse que desde alguna perspectiva, ya sucede. Si bien las IA actuales no responden con entendimiento de los sentimientos, si "comprenden" patrones o bien el significado de todos ellos, lo que en cierto modo influencia sus respuestas.

¿Toma de Decisiones Contextual?: Una IA más avanzada podría considerar no solo datos duros (con los que se la alimenta), sino también el contexto ético y emocional de las decisiones que toma. Esto sería el enseñarle todos los contextos legales y morales, al menos desde una perspectiva de relación e importancia entre ellos. El problema que podría haber aquí es: ¿A quién se considera lo suficientemente idóneo para definir en una IA estas importancias?.

¿Autonomía Condicionada?: Sería posible que una IA aprenda a ajustar su comportamiento de forma más independiente, basándose en experiencias pasadas y nuevas interacciones. A día de hoy esto es también algo que sucede. Cada interacción con una inteligencia artificial, produce un "aprendizaje" en su nivel de proceso de datos, lo que hace que sus próximas respuestas, sean más acertadas, o bien elaboradas. Pero una vez más, está limitado por el cómo ha sido programada

Sin embargo creo qué, incluso en este escenario, la IA seguiría siendo un sistema programado para ejecutar tareas. No tendría una verdadera experiencia interna, porque no habría un "yo" que experimente esas decisiones.

Pensemos en una Metáfora para intentar Entenderlo

Pensemos en la conciencia humana como un lienzo lleno de colores vibrantes que fluyen y cambian con el tiempo. Ahora imagina que la IA es una impresora de alta precisión. Puede replicar la imagen con asombroso detalle, pero no sabe qué es el arte, ni entiende la emoción que está detrás del lienzo, ni mucho menos, lo que otras consciencias humanas perciben de dicho lienzo.

Por eso, aunque la IA pueda parecer consciente desde fuera, siempre será una interpretación superficial de algo mucho más profundo. Podría imitarnos con gran fidelidad, pero sin nunca alcanzar la chispa inexplicable que hace que nosotros, como humanos, sintamos, soñemos y nos preguntemos sobre nuestra propia existencia.

¿Deberíamos Querer Que la IA Sea Consciente?

Y aquí hay una última reflexión: ¿realmente queremos crear una IA consciente?. Si una IA desarrolla conciencia, ¿tendríamos la obligación ética de tratarla como un ser con derechos?. Tal vez la verdadera lección está en usar la IA para ayudarnos a entendernos mejor a nosotros mismos: qué significa estar conscientes, qué valoramos de la experiencia humana, y cómo podemos vivir con más propósito en un mundo donde cada vez dependemos más de las máquinas.

En el fondo, la IA puede ser una herramienta para reflejarnos a nosotros mismos, no para reemplazarnos.

¿Y no es esa, al final, una lección profundamente estoica?.

Filosofía Estoica

Explora el estoicismo y su aplicación diaria.

Crecimiento, AUTOCONFIANZA, AUTOCONTROL

© 2024. All rights reserved.